Editor’s Note: บทความนี้ปรับปรุงล่าสุดปี 2025 โดยเพิ่มผลทดสอบ Benchmark การใช้งานภาษาไทย และเปรียบเทียบค่าใช้จ่าย Hidden Cost ที่ Cloud Provider ไม่เคยบอกคุณ

แต่ปัญหาที่ Developer หลายคนเจอ (และผมเองก็เจ็บมาเยอะ) คือการเลือก Database ผิดตัว

- เลือก Pinecone เพราะคิดว่าง่าย แต่พอ Scale แล้วค่า Bill รายเดือนพุ่งจน CFO เรียกคุย

- เลือก Milvus เพราะเห็นฟีเจอร์เยอะ แต่ทีม Dev ต้องเสียเวลา 50% ไปกับการแก้ปัญหา Kubernetes แทนที่จะได้เขียนโค้ด

- ทำระบบ RAG ภาษาไทย แต่ค้นหาไม่เคยเจอ เพราะเลือก Embedding Model ที่ตัดคำไทยไม่เป็น

บทความนี้จะไม่ใช่แค่การแปล Docs มาให้อ่าน แต่จะแชร์ “แผลสด” และ “คำแนะนำ” จากการใช้งานจริง เพื่อให้คุณเลือกเครื่องมือได้เหมาะกับงานและงบประมาณที่สุด

1. เข้าใจ Vector Database แบบไม่ท่องจำ (The Core Concept)

ถ้าเปรียบเทียบให้เห็นภาพ:

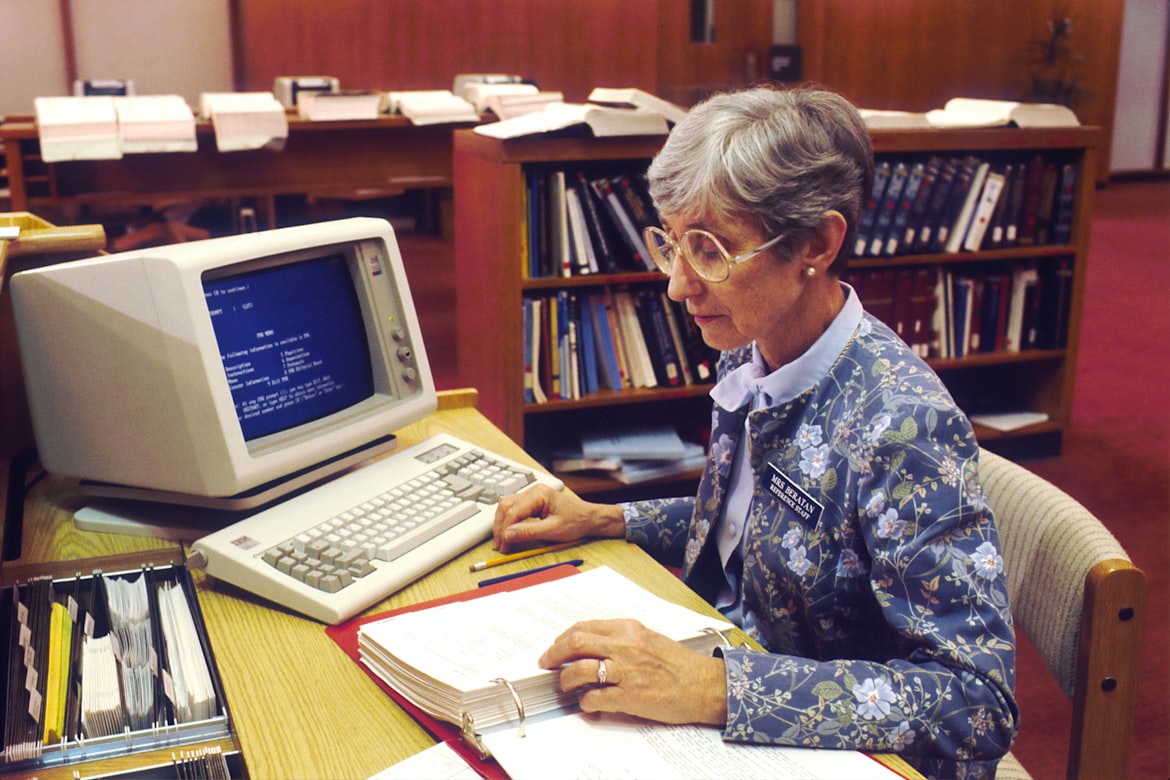

- Traditional DB (SQL): เหมือนห้องสมุดที่จัดหนังสือตามหมวดหมู่ (Category) หรือชื่อเรื่อง เป๊ะๆ

- Vector DB: เหมือนบรรณารักษ์ที่ “อ่าน” หนังสือทุกเล่มแล้วจำ “เนื้อหา” ได้ ถ้าคุณเดินไปบอกว่า “อยากได้นิยายที่อ่านแล้วรู้สึกเหงาจับใจ” บรรณารักษ์คนนี้จะหยิบหนังสือมาให้ถูก แม้ชื่อเรื่องจะไม่มีคำว่า “เหงา” เลยก็ตาม

การทำงานเบื้องหลังคือการแปลงข้อมูล (Text/Image) เป็นตัวเลขชุดหนึ่ง (Vector) ผ่าน Embedding Model และจัดเก็บไว้เพื่อหาความเหมือน (Similarity Search)

2. รีวิว 4 ตัวตึง Vector DB จากประสบการณ์จริง (Real-World Review)

จากการทดสอบและส่องดู Production Environment ของหลายๆ โปรเจกต์ นี่คือจุดดี-จุดด้อยที่คุณต้องรู้:

1. Milvus: พี่ใหญ่สาย Enterprise (The Scalability King)

- เหมาะกับใคร: องค์กรที่มีข้อมูลระดับ 100 ล้าน Vectors ขึ้นไป และมีทีม DevOps ที่แข็งแกร่ง

- The Ugly Truth (เรื่องจริงที่ต้องรู้): Milvus ทรงพลังมาก (Feature ครบสุดๆ ทั้ง Hybrid Search, GPU support) แต่แลกมาด้วยความซับซ้อนในการติดตั้งและดูแล การรัน Milvus แบบ High Availability บน Kubernetes ไม่ใช่เรื่องเล่นๆ มี learning curve สูง

- คำแนะนำ: ถ้าคุณไม่มีทีม Infra แยก อย่าเพิ่งรีบใช้ตัวนี้ (หรือถ้าจะใช้ ให้ยอมจ่าย Zilliz Cloud ไปเลยเพื่อตัดปัญหา)

2. ChromaDB: ขวัญใจสาย Prototyping (Developer Friendly)

- เหมาะกับใคร: Solo Developer, โปรเจกต์ LLM เริ่มต้น, หรือแอปฯ ที่ข้อมูลไม่เยอะ (< 1 ล้าน Vectors)

- The Ugly Truth: มันง่ายสุดๆ (pip install จบ) แต่ข้อเสียคือประสิทธิภาพจะตกลงอย่างเห็นได้ชัดเมื่อข้อมูลเริ่มเยอะ และฟีเจอร์ Advanced Indexing ยังสู้รุ่นพี่ไม่ได้

- คำแนะนำ: เริ่มต้นที่ Chroma เสมอเพื่อทำ MVP พอระบบเริ่มโตค่อยวางแผน Migrate ไปตัวอื่น

3. Qdrant: ม้ามืดสาย Performance (Rust-based Speed)

- เหมาะกับใคร: ระบบที่ต้องการความเร็วระดับ Real-time และความยืดหยุ่นในการ Filter ข้อมูล

- จุดเด่น: เขียนด้วยภาษา Rust ทำให้จัดการ Memory ได้ดีมาก และมีฟีเจอร์ “Payload Filtering” ที่เก่งกว่าเจ้าอื่น (เช่น หา Vector ที่เหมือนกัน + เงื่อนไข WHERE age > 20 ทำได้เร็วมาก)

- คำแนะนำ: เป็น Sweet Spot ที่ดีที่สุดตอนนี้ ระหว่างความง่าย (Docker ตัวเดียวจบ) กับประสิทธิภาพ

4. Pgvector: เมื่อ SQL เดิมก็ทำได้ (The Safe Bet)

- เหมาะกับใคร: ทีมที่ใช้ PostgreSQL อยู่แล้ว และไม่อยากเปิด Stack ใหม่

- จุดเด่น: ไม่ต้องเรียนรู้เครื่องมือใหม่ ใช้ SQL query ร่วมกับ Vector search ได้เลย สะดวกเรื่อง Transaction (ACID)

- The Ugly Truth: ประสิทธิภาพ (Speed/Recall) ยังสู้ Vector DB แท้ๆ (Native) ไม่ได้ 100% แต่เพียงพอสำหรับ 90% ของ Use case ทั่วไป

3. Critical Factor: เลือกยังไงไม่ให้เจ็บตัว (Decision Framework)

ตารางเปรียบเทียบเพื่อการตัดสินใจ โดยเน้นที่ “ต้นทุนแฝง” (Hidden Cost)

| Database | ค่า License/Usage | ค่า Infra (RAM/CPU) | ค่าดูแลรักษา (Engineering Cost) | คะแนนความคุ้มค่า |

|---|---|---|---|---|

| Pinecone | แพง (คิดตาม Read/Write) | 0 (Managed) | ต่ำมาก (Zero Ops) | ⭐⭐⭐⭐ (ถ้างบถึง) |

| Milvus (Self-hosted) | ฟรี | สูง (กินทรัพยากรดุ) | สูงมาก (ต้องมีผู้เชี่ยวชาญ) | ⭐⭐⭐ (เฉพาะงาน Scale ใหญ่) |

| Qdrant / Weaviate | ฟรี (Open Source) | ปานกลาง | ปานกลาง | ⭐⭐⭐⭐⭐ (Best Balance) |

| Pgvector | ฟรี (ติดมากับ PG) | ต่ำ (แชร์กับ DB เดิม) | ต่ำมาก | ⭐⭐⭐⭐ (คุ้มสุดถ้ามี PG) |

4. Unique Angle: ประเด็น “ภาษาไทย” ที่ Dev ต่างชาติไม่บอกคุณ

นี่คือส่วนที่สำคัญที่สุดสำหรับ Developer ชาวไทย การทำ RAG ภาษาไทยมักเจอปัญหา “ค้นหาไม่เจอ” ทั้งที่มีข้อมูล สาเหตุหลักคือ Tokenization

ภาษาไทยไม่มีเว้นวรรคเหมือนภาษาอังกฤษ โมเดลมาตรฐานที่มากับ Vector DB ส่วนใหญ่ (เช่น all-MiniLM-L6-v2) มักจะตัดคำไทยแบบมั่วๆ ทำให้ความหมายเพี้ยน

💡 Recommendation for Thai RAG 2025:

หากคุณทำระบบภาษาไทย ห้ามใช้ Default Model เด็ดขาด ให้เปลี่ยนมาใช้ตัวเลือกเหล่านี้:

- WangchanBERTa (จาก VISTEC):

- ข้อดี: เข้าใจบริบทภาษาไทยดีที่สุด ตัดคำแม่นยำ (ใช้ NewMM)

- ข้อเสีย: อาจจะ Setup ยากกว่านิดหน่อย และกิน Resource พอสมควร

- Multilingual-E5 (e.g., intfloat/multilingual-e5-large):

- ข้อดี: เป็นตัวเลือกยอดนิยมในปี 2025 ทำคะแนน Benchmark (MTEB) ได้สูงมาก รองรับหลายภาษาพร้อมกัน

- คำแนะนำ: ถ้าทำ Chatbot ที่คุยไทยคำอังกฤษคำ ให้ใช้ตัวนี้

- BGE-M3 (BAAI General Embedding):

- ข้อดี: รองรับ Multi-linguality ดีเยี่ยม และรองรับ input ยาวๆ ได้ดี

Pro Tip: ก่อนทำ Indexing ข้อมูลภาษาไทย ควรทำ Preprocessing (Clean ข้อมูล, ลบ Space ที่ไม่จำเป็น) และทดสอบ Tokenizer ก่อนเสมอว่ามันตัดคำสำคัญของคุณถูกต้องหรือไม่

5. กับดักที่ต้องระวัง (Production Pitfalls)

จากประสบการณ์จริงใน Reddit และ StackOverflow ปี 2024-2025 พบปัญหาที่คนตกม้าตายบ่อย:

- Memory Leak ใน Long-running Service: บาง Library (ขอไม่เอ่ยชื่อ) มีปัญหา Memory บวมเมื่อรันไปนานๆ ต้องหมั่น Monitor RAM Usage

- Re-indexing Time: เมื่อคุณเปลี่ยน Embedding Model คุณต้อง Re-index ข้อมูลใหม่ “ทั้งหมด” ถ้าข้อมูลมีเป็นล้าน Record นี่คือหายนะของการรอคอย วางแผนเรื่อง Versioning ของ Model ให้ดีตั้งแต่แรก

- Latency vs Accuracy: การจูนค่า HNSW (index type) เป็นศิลปะ ถ้าจูนให้หาเร็ว ความแม่นยำอาจตก ถ้าเอาแม่นยำ อาจจะช้า ต้องหาจุดสมดุลที่ User รับได้

บทสรุป: ปี 2025 ใช้อะไรดี?

- ทีมเล็ก / MVP: เริ่มที่ ChromaDB หรือ Pgvector (ถ้ามี Postgres อยู่แล้ว)

- ทีมกลาง / Scale ได้: ไปที่ Qdrant หรือ Weaviate

- Enterprise / Big Data: Milvus หรือ Elasticsearch (OpenSearch)

- Money is no object: Pinecone แล้วเอาเวลาไปโฟกัสที่ Product

การเลือก Vector Database ไม่มีคำว่า “ดีที่สุด” มีแต่คำว่า “เหมาะสมที่สุด” หวังว่าบทความนี้จะช่วยให้คุณประหยัดเวลาลองผิดลองถูก และเริ่มต้นโปรเจกต์ AI ได้อย่างมั่นคงครับ